企業如何挑選 AI 伺服器?2026 AI 伺服器採購攻略

2025 年是 AI 模型百花齊放的一年,ChatGPT、Gemini、Midjourney……各家模型你追我趕,背後都倚賴同一個核心:算力。而撐起這股算力的,就是「AI 伺服器」。

對於企業決策者、IT 採購或投資人來說,2026 年則是企業尋求「AI 落地」的關鍵時刻,單純依賴公有雲(Public Cloud)已然不夠,AI 伺服器將是攸關競爭力的關鍵。

本文將深入淺出地解析 AI 伺服器的核心架構,並探討企業為何正從雲端轉向「邊緣運算(Edge AI)」的自建架構趨勢,並以 EnGenius 企業級伺服器為例,解析現代化資料中心的硬體標竿。

文章目錄

什麼是 AI 伺服器?驅動生成式 AI 的核心引擎

AI 伺服器廠商有哪些?

為什麼企業需要 AI 伺服器?

AI 伺服器該用雲端還是地端?

AI 伺服器有哪些種類?

企業該買哪一種 AI 伺服器?以 EnGenius 為例

部署後的挑戰:管理與能源效率

FAQ:常見問題解答

什麼是 AI 伺服器?驅動生成式 AI 的核心引擎

AI 伺服器是為了讓人工智慧模型真正跑得動而誕生的運算系統。在生成式 AI 與深度學習需求爆發下,單靠 CPU 的傳統伺服器已無法應付龐大的運算量,而 AI 伺服器採用了「異質運算」架構,透過整合 GPU(圖形處理器)、NPU(神經網路處理器)或 FPGA 等加速器,來分擔繁重的推論與訓練負載。

CPU 像是個專才,擅長處理複雜的邏輯與順序控制;而 GPU 則像是擁有數千隻手的通才,非常適合處理 AI 模型訓練中海量的平行運算數據。

AI 伺服器的關鍵特徵有以下 3 項:

1. 異構運算:通常是一顆 CPU 搭配多顆 GPU(例如 1 顆 CPU 配 8 顆 H100 GPU)。

2. 高頻寬記憶體(HBM):為了讓資料能快速進出 GPU,使用比傳統 RAM 快上數倍的 HBM。

3. 散熱系統:運算會產生極高熱能,因此常配備液冷(Liquid Cooling) 或特殊的氣冷系統。

| 比較項目 | 傳統伺服器 (General Purpose) | AI 伺服器 (AI Server) |

|---|---|---|

| 核心運算單元 | CPU 為主 | CPU + GPU / NPU / ASIC |

| 擅長任務 | 網頁託管、資料庫查詢、邏輯運算 | 深度學習訓練、推論、影像辨識 |

| 運算模式 | 序列運算 (Serial Computing) | 平行運算 (Parallel Computing) |

| 散熱需求 | 氣冷為主 | 高階機型多需液冷或強化氣冷 |

| 成本結構 | 相對較低 | 極高 (GPU 成本佔比大) |

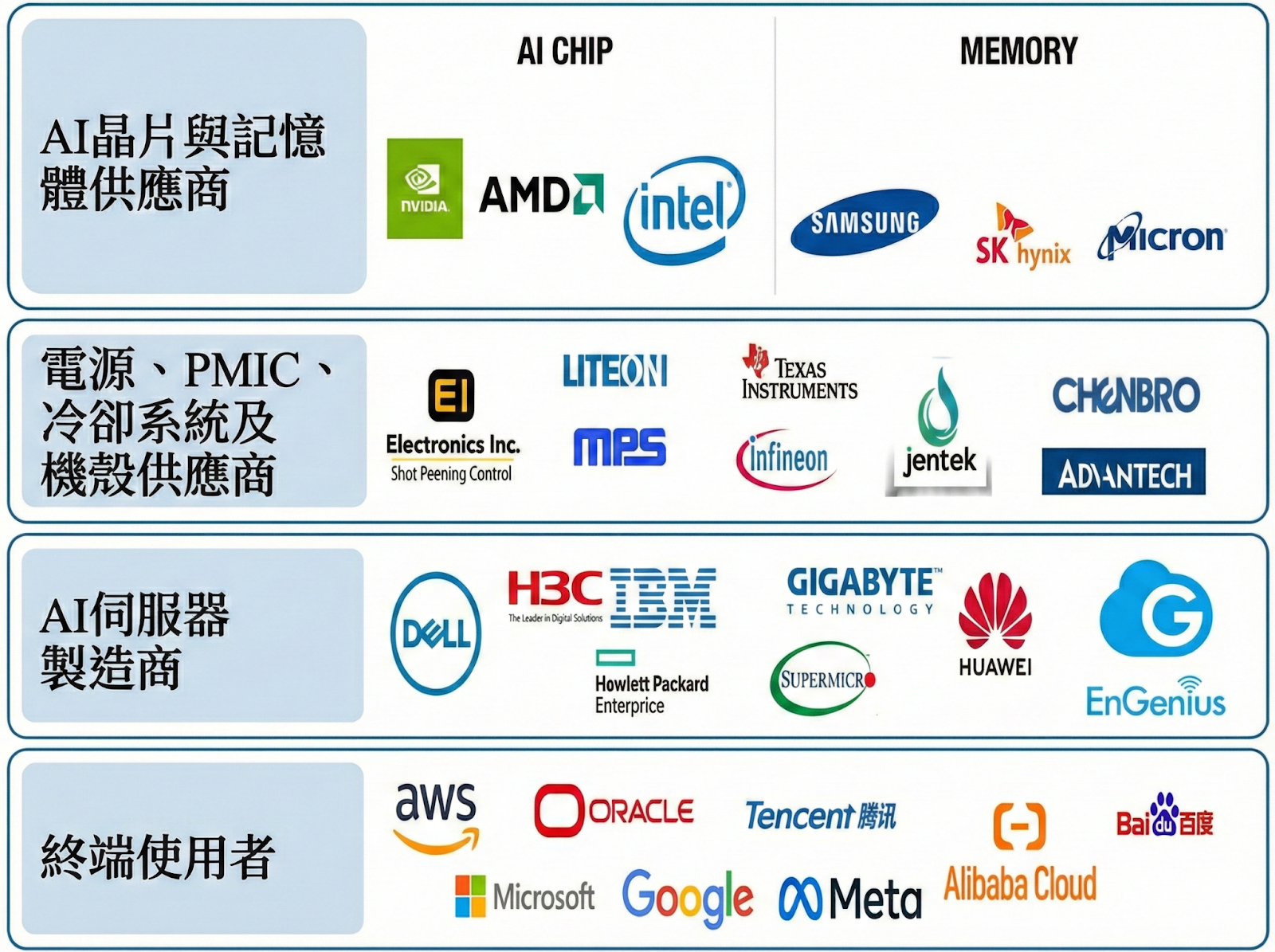

AI 伺服器廠商有哪些?

在 AI 伺服器這個龐大的產業中,伺服器製造商是把 AI 算力真正做出來、交到企業手上的關鍵角色。

目前市場上主要分為三類:

第一類是國際一線品牌:如 Dell、HPE、IBM,他們擁有完整的全球通路與企業級服務能力,常被大型企業採用。

第二類是亞洲硬體與供應鏈強者:包括台灣的技嘉(Gigabyte)、美超微(Supermicro)、恩碩(EnGenius),以及中國的 Huawei、H3C,這些廠商擅長硬體設計與成本控制,在 AI 伺服器市場競爭力極高。

第三類則是網通整合專家:例如 Cisco,利用本身在高速網路與資料傳輸的優勢,切入 AI 伺服器,解決大量運算下的傳輸瓶頸。

這些伺服器製造商向上整合 NVIDIA、AMD、Intel 等 AI 晶片,以及 Samsung、SK Hynix、Micron 的高頻寬記憶體,同時搭配 Delta、LiteOn、Advantech 等廠商的電源、散熱與機構設計。最終,這些高度整合完成的 AI 伺服器,會被交付給 AWS、Google、Microsoft、Meta 等雲端服務商,或是各產業企業,用來支撐聊天機器人、影像辨識與推薦系統等 AI 應用。

為什麼企業需要 AI 伺服器?

企業對 AI 伺服器的需求之所以全面引爆,關鍵在於應用場景從昂貴的「模型訓練」轉向了務實的「模型推論(Inference)」。對 90% 的公司來說,我們不需要像科技巨頭那樣燒幾千張 GPU 去從頭訓練大腦,而是要直接用訓練好的大腦來解決問題,像是執行 RAG 企業知識庫或產線影像辨識。

當金融風控、製造檢測到零售行銷都急著把累積多年的大數據變現,這種「拿來即用」的算力需求,才是真正撐起市場的主力,也促成 AI 伺服器的需求逐年上升。TrendForce 預估,在 2025 年 AI 伺服器會占整體伺服器市場總值的 72%。

AI 伺服器該用雲端還是地端?

企業在選購和評估 AI 伺服器時,最常陷入的誤區不是預算不夠,而是「買錯用途」。如果一開始就把場景搞錯,往往會導致花大錢買了頂級 GPU,實際跑起來卻效能過剩,甚至因為架構不合而卡在傳輸瓶頸。

地端 AI 伺服器主要適用於以下三個場景:

1. 總體擁有成本(TCO) 優化:雲端算力隨使用量計費,對於全天候運作的監控或客服系統,長期租賃成本遠高於硬體買斷。

2. 極低延遲(Ultra-Low Latency):智慧工廠的 AOI 瑕疵檢測要求毫秒級反應,無法容忍資料往返雲端的網路波動。

3. 數據主權與資安:金融、醫療與研發數據涉及敏感隱私,地端部署(On-premise)能確保原始數據不離開內網,符合零信任(Zero Trust)架構要求。

簡單來說,應用類的模型如產線瑕疵檢測、企業知識庫問答、即時影像分析,都會推薦用地端 AI 伺服器。

AI 伺服器有哪些?

AI 的算力來源,決定了伺服器的角色與適用場景。依照核心運算晶片的不同,AI 伺服器大致可分為 GPU 加速型與 CPU AI 加速型。

GPU 加速型 AI 伺服器:這類 AI 伺服器以 GPU 為主要算力來源,適合超大模型訓練或極高算力需求的推論場景。包含 NVIDIA (H100, H200, GB200) 與 AMD (Instinct MI300X)。此外,部分雲端服務商也發展自研 ASIC 晶片(如 Google TPU),但這類方案多為雲端內部使用。

CPU 加速型 AI 伺服器:在多數企業 AI 應用中,真正的需求並非大規模模型訓練,逐漸轉向新一代 CPU 導入 AI 加速設計,著名大廠如 Intel。相較於 GPU 架構,CPU AI 加速型伺服器的優勢在於成本與通用性:不需額外配置昂貴 GPU,即可滿足多數企業推論需求。以 EnGenius(恩碩科技) 推出的 DC-MHS S21 / S11 AI 伺服器為例,該系列即以 CPU 內建算力為核心,專注於企業私有雲與 Edge AI 應用。

企業該買哪一種 AI 伺服器?以 EnGenius 伺服器為例

當企業決定要建立自己的運算架構時,挑選一台合適的 AI 伺服器,往往就直接決定了專案的成敗。以 EnGenius 推出的 EnGenius DC-MHS 伺服器為例,其設計邏輯正好反映了當前企業對高效能基礎設施的標準。

1. 異質運算的極致:Intel® Xeon® 第六代處理器

為了應對複雜的混合工作負載,EnGenius 伺服器採用雙顆 Intel® Xeon® 6 處理器設計。P-core(效能核心)負責處理高強度的 AI 運算,而 E-core(效率核心,單顆 CPU 最高支援 144 核)則專門處理高併發的平行任務。搭配內建的 AMX 矩陣運算引擎,能在不加裝額外 GPU 的情況下,有效加速 NLP 與影像辨識任務。

2. 解決 CPU 瓶頸:SmartNIC 技術

在傳統架構中,CPU 常常因為要處理網路封包與加密解密而分身乏術。先進的伺服器設計會導入 SmartNIC(智慧網卡),將防火牆、加密與封包檢查等任務從 CPU 移交給網卡處理。這不僅大幅強化了資安韌性,更讓寶貴的 CPU 算力能全心投入 AI 運算。

3. 對抗技術迭代:DC-MHS 模組化架構

EnGenius 採用 DC-MHS 模組化硬體系統,支援高達 8TB 的 DDR5 記憶體與 8 組 PCIe 5.0 插槽。這意味著企業可以隨著 AI 模型變大,彈性加裝更多 GPU 或 NVMe SSD(最高 24 顆 U.2),而無需整機汰換。

無論你是想要升級現有的機房架構,還是正準備從零開始部署企業私有雲,EnGenius 都能提供最適合的彈性方案。現在就點擊下方連結,探索專屬於你的高效運算解方。

👉 立即前往 EnGenius 台灣官方旗艦店: https://tw.store.engeniustech.com/

AI 伺服器部署後的挑戰:管理複雜度與能源效率

AI 伺服器到位後,企業 IT 團隊面臨的下一個挑戰是「管理」。現代化的解決方案如 EnGenius Data Center Controller(EDCC),採用了 Redfish 標準架構。它提供了一個集中式的管理介面,讓管理者可以在單一螢幕上監控跨機架的硬體狀態、執行韌體更新,解決了多節點管理的痛點。

此外,能源效率(PUE)也是不可忽視的指標。EnGenius 採用鈦金級(Titanium)電源模組(M-CRPS),轉換效率高達 96%,這在全天候運轉的資料中心裡,能節省可觀的電力成本,也是間接幫助企業 ESG 評核的重要措施。

2026 AI 伺服器市場展望與結語

AI 市場正從早期的「模型訓練階段」,正式邁入大規模的商業應用期。根據 TrendForce 最新產業報告,2026 年全球 AI 伺服器出貨量預計將維持 20% 以上年增率,並佔整體伺服器市場比重達 17%。具備模組化設計、高效率 CPU 異質運算與集中化管理能力的現代化 AI 伺服器,正成為企業推動 AI 落地時,平衡效能與成本的關鍵選擇。

FAQ:關於 AI 伺服器與部署的常見問題

Q1: 什麼是 AI 伺服器?

AI 伺服器是專門用來執行人工智慧應用的高效能伺服器。和一般伺服器不同,它能同時處理大量資料,適合用於 AI 模型訓練與推論。AI 伺服器通常搭載 GPU、NPU 或具備 AI 加速功能的處理器,讓運算速度更快、效率更高。為了應付高算力需求,這類伺服器也具備高速資料傳輸與強化散熱設計,常被企業用在聊天機器人、影像辨識、推薦系統等 AI 應用情境。

Q2: AI 伺服器跟一般伺服器有什麼不一樣?

最大的差別在於「平行運算能力」。一般電腦(使用 CPU)一次處理一件事情,做得很快;AI 伺服器(使用 GPU/NPU)可以同時處理成千上萬件簡單的事情,這正是 AI 模型訓練所需要的特性。此外,AI 伺服器的記憶體頻寬、散熱設計和電源供應都遠高於一般電腦標準。

Q3: 公司想導入 AI,一定要買最貴的 GPU 伺服器嗎?

不一定。如果是執行「推論」任務(例如使用已經訓練好的模型來辨識圖片),通常不需要用到訓練級的頂規 GPU。採用具備 AMX 加速功能的現代 CPU(如 Intel Xeon 6)或是中階推論卡,往往就能滿足需求且成本大幅降低。

Q4: 該如何挑選適合的 AI 伺服器?

這取決於企業的「應用場景」與「部署需求」。首先釐清是用於「模型訓練」還是「推論」?90% 的企業應用(如瑕疵檢測、RAG)屬於推論,因此選擇具備 AI 加速指令(如 Intel Xeon 6)的 CPU 伺服器更能平衡效能與成本。其次,考量「雲端或地端」。若重視低延遲、資料隱私與長期 TCO,應選擇地端伺服器。建議挑選具備 SmartNIC 技術與模組化設計(DC-MHS)的機型,確保算力專注於 AI 並保有未來擴充彈性。

Q5: 如何購買 Engenius AI 伺服器?

只要到 EnGenius 台灣官網,進入 Data Center AI Servers 專區查看產品規格,並在產品頁點選 「聯絡我們/詢價」,填寫所需的算力與配置需求,官方團隊就會主動聯繫,協助規劃並提供報價。

投入 AI 伺服器,佈局企業未來

面對 2026 年的 AI 競爭,擁有穩定的運算基石是企業成功的關鍵。選擇合適的 AI 伺服器,將為您的數位轉型提供最強大的動力支援。